مقال | جوجل تتحدى إنفيديا: هل شريحة TPU Ironwood قادرة على كسر الاحتكار

في نوفمبر 2025، أطلقت جوجل شريحة TPU Ironwood من الجيل السابع بأداء استدلال متفوقة، وأعلنت صفقة مع Anthropic بقيمة “عشرات المليارات” للوصول إلى مليون وحدة TPU بحلول 2026.

لكن هل هذا يعني أن هيمنة إنفيديا على 80-90% من سوق شرائح الذكاء الاصطناعي ستنهار؟ الإجابة أكثر تعقيداً مما يبدو على السطح.

بينما جوجل تملك مزايا تقنية حقيقية وجدول أسعار أفضل، فإن حواجز عملية وتنافسية قوية ستحد من قدرتها على الاستحواذ السريع على حصة كبيرة من السوق.

بداية الطريق : كيف وصلت قوقل الى هذا النقطة

قبل أكثر من عقد، اكتشفت جوجل مشكلة استراتيجية: تطبيقاتها الضخمة (البحث، YouTube، الترجمة) تستهلك طاقة حوسوبية هائلة، وكانت معتمدة بشكل كامل على شرائح Nvidia و معالجات خادم عامة.

ولتحرير نفسها من هذا الاعتماد، استثمرت جوجل في تطوير شرائح متخصصة تُسمى Tensor Processing Units (TPUs) مصممة حصريًا لمعالجة عمليات الشبكات العصبية.

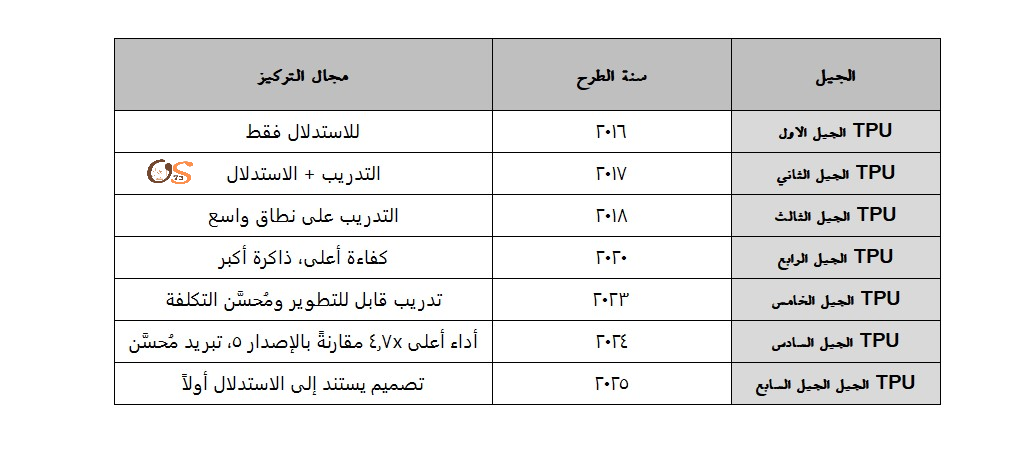

حيث انها من عام 2015 الى 2024 قامت شركة قوقل بتطوير ستة اجيال من TPUs:

TPU v1-v3 (2015-2018): مصممة للاستدلال والتدريب الداخلي

TPU v4-v5 (2019-2023): توسيع السكيل إلى مئات آلاف الشرائح

TPU v6e/v6p (2024): تحسينات في الأداء والكفاءة

لم تُسوّق جوجل هذه الشرائح للعملاء الخارجيين بقوة حتى 2024-2025، مفضلة استخدامها داخليًا أو عبر Google Cloud بنموذج الساعات/الاشتراك.

جدول الزمني : لتطور TPU

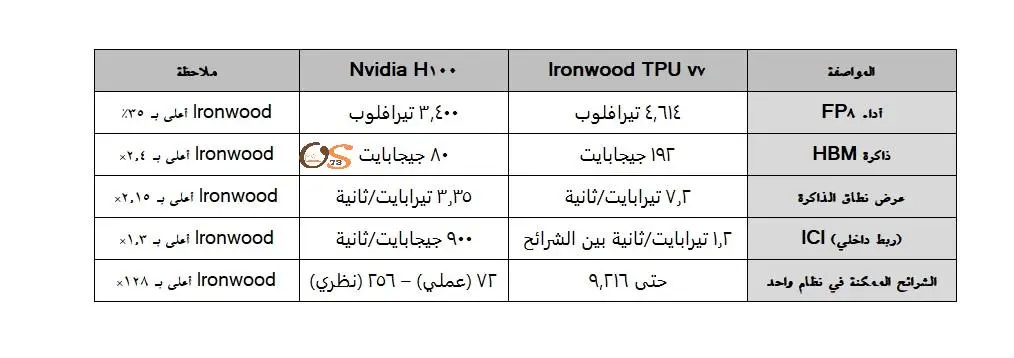

مقارنة الموصفات : بين TPU Ironwood v7 VS H100

سوف نقوم بمقارنة بينهم بناء على المصادر المتاحة مع ترك المصادر اسف الجدول لمرجعتها :

بناء على الجدول نجد أن Ironwood متفوق في الاستدلال على نطاق ضخم، لكن H100 لا يزال أفضل في التدريب العام والمرونة.

المصادر :

مايجب فهمه : عن الاداء النظري مقابل العملي

جوجل تدّعي أن 9,216 شريحة في بود واحد توفر 42.5 إكزا-فلوبس. بينما هذا مثير، يجب أن نفهم:

Overhead الشبكة: ليس كل الأداء النظرية متاحة عمليًا؛ تواصل الشرائح يحتاج وقتًا

الـ 400,000 شريحة “النظرية”: لم تُختبر قط، وقد تواجه مشاكل غير متوقعة عند التوسع لهذا الحد

المقارنة الأكثر واقعية: Ironwood أفضل في الاستدلال المستقر (نماذج ثابتة محسّنة)، بينما H100 أفضل في التدريب المتنوع (بحث، تجريب، نماذج جديدة)

Gemini 3 : دليل على القدرات ولكن بدون مبالغة!

في نوفمبر 2025، أطلقت جوجل Gemini 3 Pro، والذي حقق نتائج متقدمة في اختبارات معيارية:

LM Arena: 1501 نقطة Elo (تصدر اللوائح)

GPQA Diamond: 91.9% (اختبار صعب بشكل مقصود)

ARC-AGI 2: 45.1% (مقياس الحل الإبداعي للمشاكل)

وبالتالي ماذا تعني هذه النتائج:

1- Gemini 3 نموذج متقدم جدًا، مقارنة بمعايير 2024-2025

2- تم تدريبه على TPU v6e و Ironwood، مما يثبت أن TPUs يمكنها بناء نماذج متقدمة

لكن، لا تُفسّر بـ “Ironwood أفضل من H100”:

OpenAI’s GPT-4o و Claude 3.5 Sonnet متقدمان أيضًا، وتم تدريبهما على H100s

التفوق في البنشمارك قد يعكس اختيارات التدريب والبيانات، وليس العتاد فقط

التكلفة التقدرية : لصناعة شريحة H100

شركة Nvidia تبيع H100 بـ $25,000-40,000 للوحدة حسب النسخة والسوق ، والهامش 82200% على أقل التقديرات ، ودعنا نشرح ذلك بالارقام ، مع ترك المصادر اسفل الجدول

تكاليف التصنيع الحقيقية لـ H100:

من خلال التكاليف الحقيقة لصناعة الشريحة الى الارباح العالية والغير مبررة ، سوف نكتشف لماذا تعتبر انفديا اكبر الشركات قيمة سوقية حالياً .

المصادر :

التكلفة التقدرية : لنسخة المختلفة Ironwood

الان سوف نقوم بحسبة تقدرية لشريحة قوقل ، في البداية يجب ان نعلم ان قوقل لم تحاول بناء شريحة “أرخص“ من حيث التصنيع. في الحقيقة، Ironwood أعقد وأغلى من H100 من حيث المكونات.

تكاليف تصنيع Ironwood:

المصادر :

حساب العائد : على الاستثمار الحقيقي

اولا : سناريو Nvidia و H100

شركة تقوم بشراء 100 وحدة من H100

تكلفة رأس المال الأولي: $3 مليون (بـ $30,000 للوحدة)

تكلفة الكهرباء (350W × 5 سنوات × $0.12/كيلو وات ساعة): $20,000

التبريد والبنية: $5,000

الصيانة والدعم: $3,000

المجموع لـ 100 وحدة على 5 سنوات: ~$3,028,000

الإيرادات من استدلال النماذج:

إذا استخدمت الشركة H100 لتشغيل نماذج (مثل Claude أو Gemini) للعملاء

الإيراد النموذجي: $8-12 مليون سنويًا لـ 100 وحدة (حسب حجم الاستخدام)

على 5 سنوات: $40-60 مليون

ROI: 1,220% على 5 سنوات (أو 200% سنويًا)

ثانياً : جوجل و Ironwood (عبر Google Cloud)

على سبيل المثال نقول نفس الشركة التي في الاعلى سوف تستخدم 100 وحدة Ironwood على Google Cloud:

تكلفة رأس المال الأولي: $0 (لا تشتري الشريحة)

تكلفة الاستخدام الشهري: ~$100,000-150,000 (بـ $1,000-1,500 لكل وحدة شهريًا)

التكلفة السنوية: $1.2-1.8 مليون

على 5 سنوات: $6-9 مليون (شامل الكهرباء والتبريد والصيانة)

الإيرادات:

نفسها: $8-12 مليون سنويًا

على 5 سنوات: $40-60 مليون

ROI: 450-900% على 5 سنوات (أو 90-180% سنويًا)

الخلاصة:

للعملاء: H100 و Ironwood يعطيان ROI متشابه

لكن:

H100 يتطلب استثمار ضخم مقدماً ($3M)

Ironwood لا يتطلب استثمار أولي، فقط نفقات تشغيل

بالتالي إذا كانت الشركة صغيرة أو بدء حالتها التمويل محدود؟ Ironwood تفوز بسهولة.

التصنيع : اهم جزء في المعادلة

في الحقيقة هناك شركة واحدة فقط تقوم بصناعة الشرائح للشركتين وهيا الشركة التايوانية TSMC.

H100 : TSMC 4N (عملية مخصصة من 5nm)

Ironwood: TSMC 3N

والمشكلة الان : ان شركة TSMC لديها طاقة محدودة جداً في 3N و 4N. كل شركة تقريبًا تريد هذه العمليات وبسبب ذلك تكون النتجية :

انتظار طويل للشحنات

ارتفاع الأسعار

احتمال مشاكل الجودة عند التسريع

وبالتالي قامت جوجل حلت هذا بذكاء:

شراكات متعددة:

MediaTek: تتولى I/O والتعامل مع TSMC (استخدمت MediaTek علاقاتها القديمة للحصول على أسعار أقل)

Broadcom: تطور وحدات الأداء الأساسية

جوجل نفسها: تقود التصميم وتحتفظ بالسيطرة المعمارية

بدائل التغليف:

بدل الاعتماد على CoWoS وحده (مصنع واحد مشبع)

جوجل تستخدم عمليات تغليف بديلة أرخص وأسرع

التخطيط للإنتاج الضخم:

3-4 ملايين TPU سنويًا بحلول 2026

هذا 1.5-2 مرة أكثر من عدد H100s التي تشحنها Nvidia

المصدر :

انقسام السوق : صفقة Anthropic ماذا تعني ؟

في أكتوبر 2025، أعلنت Anthropic توسع استخدام Google Cloud TPUs والقيمة التقريبة للصفقة (عشرات المليارات).

ونستطيع الحساب الصفقة بحيث اذا كان شراء 1 مليون TPU بـ سعر نموذجي الآن (حوالي $5,000-8,000 للوحدة) سوف يكون المبلغ $5-8 مليارات فقط.

لكن الصفقة تشمل:

Google Cloud infrastructure

Support والخدمات

Long-term pricing guarantees

الإجمالي الحقيقي: $25-30 مليار على 3-5 سنوات.

ولكن في المقابل Anthropic لم تتخلى عن Nvidia كليًا

في موقع الرسمي للشركة هناك بيان رسمي من قبلهم “نستخدم TPU و Trainium و H100” وبالتالي نستطيع الاستنتاج ان الشركة لا تزال متعددة المزودين وتعتمد على التالي:

استدلال الإنتاج: TPU Ironwood

تدريب النماذج: H100s و Trainium

البحث والتطوير: كل شيء

الخلاصة : من المنتصر ؟

الإجابة: نعتقد انه كلاهما منتصر. لكن بطرق مختلفة ، وكلما زادت المنافسة بين المصنعين زاد الابداع والابتكار ونحن في نهاية المستفدين.

في الختام : سوف نترك لكم جدول بسيط يوضح المنافسة بين الشركتين بناء على الوضع الحالي بينهم.

| العامل | Nvidia | |

|---|---|---|

| هامش ربح لكل وحدة | أعلى | أقل |

| حجم الإنتاج الكلي | 2M-2.5M | 2.5M-3.5M (متوقع) |

| الإيرادات الكلية | $35-40B | ~$30-35B (متوقع) |

| الاستقرار السوقي | عالي (CUDA وارث) | متوسط (لكن ينمو سريع) |

| العملاء الجدد | قليل | كثير (أسعار أقل) |

| الربحية الإجمالية | عالية جداً | عالية (لكن متنوعة) |